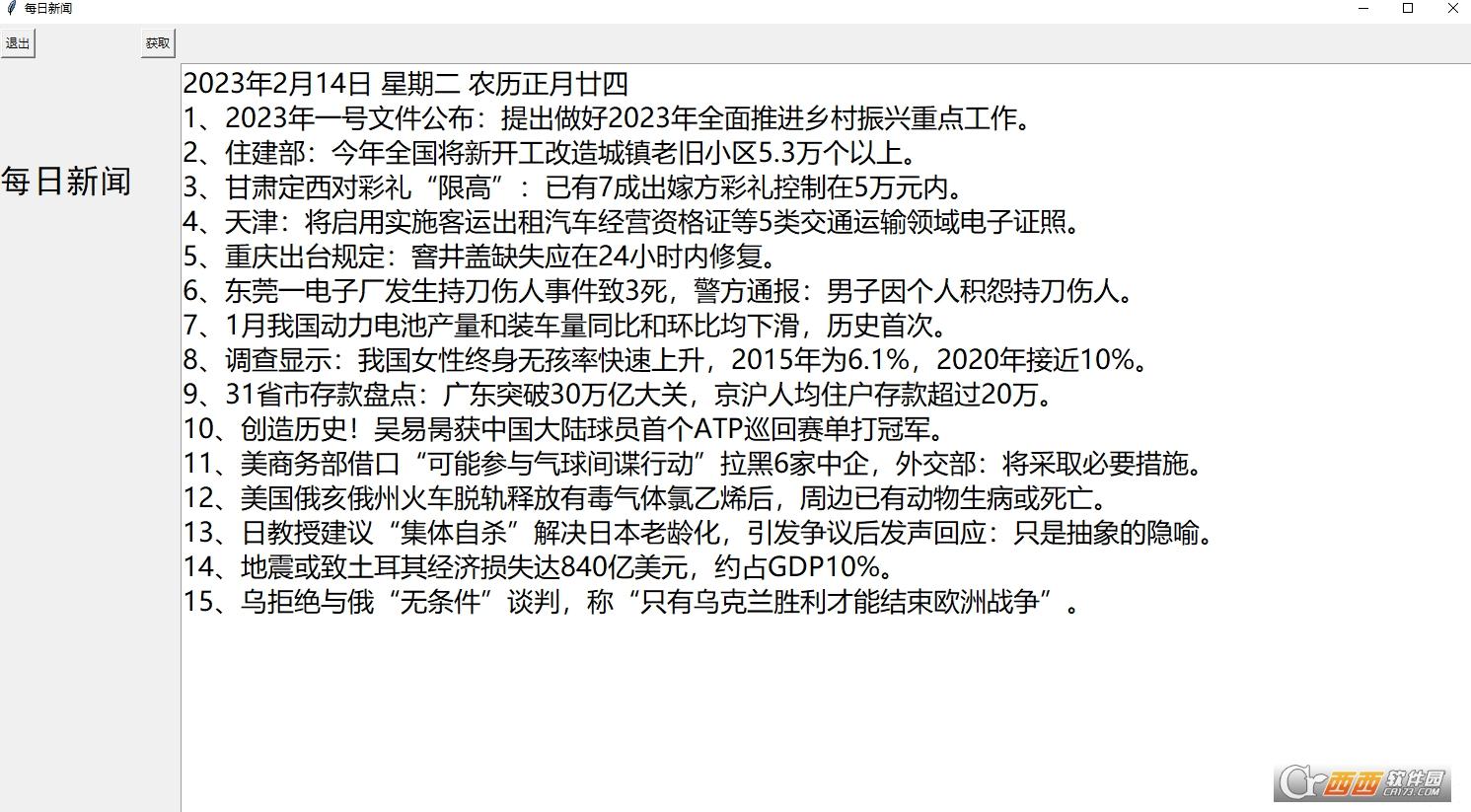

每日新闻(爬取新闻)是一款python爬虫之抓取网页新闻标题与链接的工具,每天上班想看看新闻,于是Python打包了一个可以一键点击查看新闻的exe,现在目的就是爬取有关这个关键词的网页文章,如题目、媒体、日期、内容、url。

软件说明

利用python写爬虫的人越来越多,这也表明了用python写爬虫相比其它语言用起来更方便一些。很多新闻网站都没有反爬虫的策略,所以爬取新闻网站的数据就更加方便。

异步爬虫实现的流程

1新闻源列表

本文要实现的异步爬虫是一个定向抓取新闻网站的爬虫,所以就需要管理一个定向源列表,这个源列表记录了很多我们想要抓取的新闻网站的url,这些url指向的网页叫做hub网页,它们有如下特点:

它们是网站首页、频道首页、最新列表等等;

它们包含非常多的新闻页面的链接;

它们经常被网站更新,以包含最新的新闻链接;

它们不是包含新闻内容的新闻页面;

Hub网页就是爬虫抓取的起点,爬虫从中提取新闻页面的链接再进行抓取。Hub网址可以保存在MySQL数据库中,运维可以随时添加、删除这个列表;爬虫定时读取这个列表来更新定向抓取的任务。这就需要爬虫中有一个循环来定时读取hub网址。

2网址池

异步爬虫的所有流程不能单单用一个循环来完成,它是多个循环(至少两个)相互作用共同完成的。它们相互作用的桥梁就是“网址池”(用asyncio.Queue来实现)。

这个网址池就是我们比较熟悉的“生产者-消费者”模式。

一方面,hub网址隔段时间就要进入网址池,爬虫从网页提取到的新闻链接也有进入到网址池,这是生产网址的过程;

另一方面,爬虫要从网址池中取出网址进行下载,这个过程是消费过程;

两个过程相互配合,就有url不断的进进出出网址池。

3数据库

这里面用到了两个数据库:MySQL和Leveldb。前者用于保存hub网址、下载的网页;后者用于存储所有url的状态(是否抓取成功)。

从网页提取到的很多链接可能已经被抓取过了,就不必再进行抓取,所以他们在进入网址池前就要被检查一下,通过leveldb可以快速查看其状态。

3.异步爬虫的实现细节

前面的爬虫流程中提到两个循环:

循环一:定时更新hub网站列表

asyncdefloop_get_urls(self,):print('loop_get_urls()start')while1:

awaitself.get_urls()#从MySQL读取hub列表并将huburl放入queue

awaitasyncio.sleep(50)

循环二:抓取网页的循环

asyncdefloop_crawl(self,):print('loop_crawl()start')

last_rating_time=time.time()

asyncio.ensure_future(self.loop_get_urls())

counter=0while1:

item=awaitself.queue.get()

url,ishub=item

self._workers+=1counter+=1asyncio.ensure_future(self.process(url,ishub))

span=time.time()-last_rating_timeifspan3:

rate=counter/spanprint('\tloop_crawl2()rate:%s,counter:%s,workers:%s'%(round(rate,2),counter,self._workers))

last_rating_time=time.time()

counter=0ifself._workersself.workers_max:print('======gotworkers_max,sleep3sectonextworker=====')

awaitasyncio.sleep(3)

更新说明

已更新排版好的exe

Tags:新闻内容,新闻标题,按日期.

飓风视频转换工具视频播放 / 113.99MB / 2014-9-30 / WinAll / /

飓风视频转换工具视频播放 / 113.99MB / 2014-9-30 / WinAll / / 小编点评:飓风视频转换工具是一款功能强大的,

下载 三维建模软件Remograph Remo3D3D制作 / 941.54MB / 2016-8-25 / WinAll / /

三维建模软件Remograph Remo3D3D制作 / 941.54MB / 2016-8-25 / WinAll / / 小编点评:RemographRemo3D是一.

下载 eve矢量绘图图像处理 / 363.82MB / 2014-3-13 / WinAll, WinXP / /

eve矢量绘图图像处理 / 363.82MB / 2014-3-13 / WinAll, WinXP / / 小编点评:谁能想到一个73kb的exe,能制作.

下载 小可爱表情包完整版QQ表情 / 87.37MB / 2012-11-11 / WinAll / /

小可爱表情包完整版QQ表情 / 87.37MB / 2012-11-11 / WinAll / / 小编点评:小可爱表情包是一组小猫咪可爱的表情.

下载 CD弹出器(Anti Lost CD Ejector)光盘工具 / 115.66MB / 2015-1-18 / WinAll / /

CD弹出器(Anti Lost CD Ejector)光盘工具 / 115.66MB / 2015-1-18 / WinAll / / 小编点评:AntiLostCDEjector是一款CD弹出.

下载 生日开始无限生命修改器修改器(游戏工具) / 69.7MB / 2023-9-7 / WinXP, Win7, win8 / /

生日开始无限生命修改器修改器(游戏工具) / 69.7MB / 2023-9-7 / WinXP, Win7, win8 / / 小编点评:生日开始无限生命修改器是专门为喜欢生日开始.

下载 国海证券金探号超级终端股票证券 / 608.58MB / 2012-8-26 / WinAll / / 国海证券金贝壳 /

国海证券金探号超级终端股票证券 / 608.58MB / 2012-8-26 / WinAll / / 国海证券金贝壳 / 小编点评:国海证券金探号超级终端是一款基于通.

下载 Hi英文输入法文字输入 / 937.65MB / 2023-6-27 / WinXP, windows7 / /

Hi英文输入法文字输入 / 937.65MB / 2023-6-27 / WinXP, windows7 / / 小编点评:Hi英文输入法、英文输入助手是一款.

下载 我不听我不听表情包高清无水印版QQ表情 / 628.18MB / 2022-8-4 / WinAll, Android / /

我不听我不听表情包高清无水印版QQ表情 / 628.18MB / 2022-8-4 / WinAll, Android / / 小编点评:我不听我不听表情包高清无水印版是一.

下载 Bookmarks Organizer浏览辅助 / 885.1MB / 2018-4-21 / WinAll / /

Bookmarks Organizer浏览辅助 / 885.1MB / 2018-4-21 / WinAll / / 小编点评:BookmarksOrganize.

下载 chrome猫抓嗅探神器浏览辅助 / 764.31MB / 2016-3-10 / WinAll / /

chrome猫抓嗅探神器浏览辅助 / 764.31MB / 2016-3-10 / WinAll / / 小编点评:chrome猫抓嗅探神器是一款可以帮你.

下载 Git Master浏览工具插件浏览辅助 / 787.99MB / 2013-7-27 / WinAll, WinXP, Win7, win8 / /

Git Master浏览工具插件浏览辅助 / 787.99MB / 2013-7-27 / WinAll, WinXP, Win7, win8 / / 小编点评:GitMaster浏览工具插件是Git.

下载 神树守卫战1.2正式版游戏地图 / 13.44MB / 2018-9-18 / WinAll, WinXP, Win7, win8 / /

神树守卫战1.2正式版游戏地图 / 13.44MB / 2018-9-18 / WinAll, WinXP, Win7, win8 / / 小编点评:神树守卫战1.2今天更新啦!新版本.

下载 秘密浏览器手机版下载安装-秘密浏览器app最新版下载v3.1.3 安卓版

秘密浏览器手机版下载安装-秘密浏览器app最新版下载v3.1.3 安卓版 领食周边购app下载-领食周边购官方版下载v4.0.02 安卓版

领食周边购app下载-领食周边购官方版下载v4.0.02 安卓版 富巨家软件下载-富巨家app(改名富巨智能)下载v24.0.0 安卓版

富巨家软件下载-富巨家app(改名富巨智能)下载v24.0.0 安卓版 国家奥体中心app下载-国家奥体中心预约软件下载v1.0.13 安卓版

国家奥体中心app下载-国家奥体中心预约软件下载v1.0.13 安卓版 节奏木鱼音游下载-节奏木鱼音游最新版下载v1.0.7 安卓版

节奏木鱼音游下载-节奏木鱼音游最新版下载v1.0.7 安卓版 像素英雄字节与魔法中文破解版下载-像素英雄字节与魔法汉化破解版下载v1.362 安卓版

像素英雄字节与魔法中文破解版下载-像素英雄字节与魔法汉化破解版下载v1.362 安卓版 桥梁建设模拟器游戏下载-桥梁建设模拟器手机版下载v1.0 安卓版

桥梁建设模拟器游戏下载-桥梁建设模拟器手机版下载v1.0 安卓版 嘀嗒计步器下载安装手机版-嘀嗒计步器app下载v4.8.4 安卓版

嘀嗒计步器下载安装手机版-嘀嗒计步器app下载v4.8.4 安卓版 袋熊小说app下载-袋熊小说最新版下载v1.0.10 安卓版

袋熊小说app下载-袋熊小说最新版下载v1.0.10 安卓版 菜总惠app下载-菜总惠软件下载v1.6.0 安卓版

菜总惠app下载-菜总惠软件下载v1.6.0 安卓版 手机投屏果冻app下载-手机投屏果冻软件下载v1.0 安卓版

手机投屏果冻app下载-手机投屏果冻软件下载v1.0 安卓版 川流天气最新版下载-川流天气预报app下载v1.0.0 安卓版

川流天气最新版下载-川流天气预报app下载v1.0.0 安卓版

金万维动态域名V6.2.3.0下载

网络辅助 / 106.14MB / 2011-12-22 / Win8,Win7,WinXP / 简体中文 / 免费软件 下载

网络辅助 / 106.14MB / 2011-12-22 / Win8,Win7,WinXP / 简体中文 / 免费软件 下载

EmmaSetup Lite V1.0.0下载

编程开发 / 339.17MB / 2014-2-6 / Win8,Win7,WinXP / 英文 / 免费软件 下载

编程开发 / 339.17MB / 2014-2-6 / Win8,Win7,WinXP / 英文 / 免费软件 下载

商贸财神服装鞋帽进销存管理软件V9800下载

进销存软件 / 581.65MB / 2017-11-6 / Win8,Win7,WinXP / 简体中文 / 共享软件 下载

进销存软件 / 581.65MB / 2017-11-6 / Win8,Win7,WinXP / 简体中文 / 共享软件 下载

PixMaker Pro V2.320下载

图像浏览 / 784.65MB / 2022-7-30 / Win8,Win7,WinXP / 英文 / 免费软件 下载

图像浏览 / 784.65MB / 2022-7-30 / Win8,Win7,WinXP / 英文 / 免费软件 下载

IMworks下载-即时通讯软件 v4.2.21.1

办公软件 / 854.87MB / 2012-4-3 / WinAll / 简体中文 / 免费软件 下载

办公软件 / 854.87MB / 2012-4-3 / WinAll / 简体中文 / 免费软件 下载

卡式业务进销存系统V2.0下载

其他应用 / 215.40MB / 2022-5-18 / Win8,Win7,WinXP / 简体中文 / 免费软件 下载

其他应用 / 215.40MB / 2022-5-18 / Win8,Win7,WinXP / 简体中文 / 免费软件 下载

蹭网防护器V3.1下载

网络监测 / 881.32MB / 2011-12-1 / Win7,Vista,Win2003,WinXP / 简体中文 / 免费软件 下载

网络监测 / 881.32MB / 2011-12-1 / Win7,Vista,Win2003,WinXP / 简体中文 / 免费软件 下载

Deskshare My Screen Recorder下载-屏幕录像工具 v5.30 免费版

屏幕录像 / 53.89MB / 2012-1-26 / WinAll / 英文 / 免费软件 下载

屏幕录像 / 53.89MB / 2012-1-26 / WinAll / 英文 / 免费软件 下载

宜豆找房app下载-宜豆找房安卓版下载

生活服务 / 71.10MB / 2013-4-4 / / 下载

生活服务 / 71.10MB / 2013-4-4 / / 下载

创造妖灵妖手游下载-创造妖灵妖免费版下载v4.3.1 安卓版

角色扮演 / 737.79MB / 2018-10-23 / Android / 中文 / v4.3.1 安卓版 下载

角色扮演 / 737.79MB / 2018-10-23 / Android / 中文 / v4.3.1 安卓版 下载

猫猫奇异物语官方版下载-猫猫奇异物语游戏下载v1.0.0 安卓版

模拟经营 / 647.20MB / 2019-9-15 / Android / 中文 / 葫芦岛博创互娱科技有限公司 / v1.0.0 安卓版 下载

模拟经营 / 647.20MB / 2019-9-15 / Android / 中文 / 葫芦岛博创互娱科技有限公司 / v1.0.0 安卓版 下载

九游风暴三国手机版下载-风暴三国手游九游版下载v1.1.0 安卓版

卡牌游戏 / 166.75MB / 2013-3-7 / Android / 中文 / v1.1.0 安卓版 下载

卡牌游戏 / 166.75MB / 2013-3-7 / Android / 中文 / v1.1.0 安卓版 下载

征途勇者破解版下载-征途勇者内购破解版下载v1.2.1 安卓最新版

卡牌游戏 / 802.15MB / 2013-6-29 / Android / 中文 / v1.2.1 安卓最新版 下载

卡牌游戏 / 802.15MB / 2013-6-29 / Android / 中文 / v1.2.1 安卓最新版 下载